Amazon Drive

Jeg har en del lokale data, fordi jeg har rippet alle fysiske medier og lagt det på et netværksdrev (NAS). Det er et ret stort arbejde, så selvom jeg har stadig har alle medierne, så er det rart med en backup. Derudover har jeg diverse services (Kodi, MySQL, Logitech Media Server o.a.) kørende på min pc, hvor jeg gerne vil sikre databaser, konfigurationsfiler og logs.

I en periode brugte jeg enten RAID5 eller RAID6 som beskyttelse af de data, som jeg kunne genskabe igen. Med RAID5 og 6 distribuerer man paritet ud på alle diskene, så man hhv. kan tåle at miste 1 eller 2 diske. Det beskytter dog ikke mod datakorruption, og med diske på op mod 10 TB per stk., så tager det dage eller uger for at genopbygge et array.

Når et array genopbygges, skal alle data fra alle diske læses, og i den periode er man ikke sikret. Hvis der er dårlige sektorer på de andre diske, så går hele arrayet i dørken, og alle data er tabt. De små NAS’er, som man typisk bruger som privatperson, er ikke så kraftige, og hvis ikke man bruger enterprise-diske (og det gør man typisk ikke, for de er dyre), så understøtter de kun arrays op til 6 eller 8 diske. I praksis kan de godt blive større, men så er det på “eget ansvar”.

En anden ulempe ved RAID er, at man mister brugbar kapacitet pga. paritetsdata og et mere avanceret filsystem med langt flere metadata end ext4 eller xfs på individuelle diske. Jeg har en fiberforbindelse med 300 Mbps upload, så jeg har ledt efter en online backupservice, der både var billig, hurtig og med masser af plads. De hænger ikke på træerne, hvis nogen skulle være i tvivl.

Cloud storage services

Crashplan er velkendt i markedet, og deres letvægts-klient fungerer rigtig godt. Desværre er hastigheden tæt på ubrugelig uden for USA. Backblaze er hurtig og tilbyder ubegrænset plads, men den kræver en tung javaklient og håndterer kun data, der er fysisk tilsluttet en pc. Hvis man vil sikre sine netværksdrev, så bliver det lynhurtigt alt for dyrt.

Derudover er der store spillere som Google Drive, Microsoft OneDrive og Amazon Drive. På et tidspunkt tilbød Microsoft OneDrive uden begrænsning, men da folk begyndte at uploade hele filmsamlinger, så stoppede det hurtigt igen.

Der er historier på Reddit om, at man kan “snyde” sig til ubegrænset plads hos Google, men det vil jeg ikke komme nærmere ind på her, og selvom det måske virker, så løber man en stor risiko for pludselig at miste adgangen til sine data. Den gratis Google Drive har 15 GB som standard, men har du brug for store mængder data, så bliver det også hurtigt for dyrt.

Tilbage er der Amazon Drive, hvor man via en Amazon Prime-konto kan få gratis adgang til lagring af ubegrænsede mængder billeder og op til 5 GB data. Det er dog deres “Unlimited Storage”-abonnement, der er interessant. Det koster kun $60 per år, og så får man ubegrænset dataplads.

I realiteten er det “ubegrænset” med visse forbehold. Der står noget om fair use i betingelserne, og at Amazon forbeholder sig ret til at begrænse folk, hvis de afviger væsentligt fra et normalt brugsmønster – uden i øvrigt at definere hvad væsentligt og normalt er.

Det lader til at være en gummiparagraf for at forhindre folk i at uploade flere petabytes eller bruge det som et aktivt repository. Der er mange, der har gemt flere hundrede terabyte data, så der er plads nok til selv seriøse datahoarders.

Den største bekymring ved Amazon Drive er denne formulering i deres terms of use:

You give us the right to access, retain, use and disclose your account information and Your Files: to provide you with technical support and address technical issues; to investigate compliance with the terms of this Agreement, enforce the terms of this Agreement and protect the Service and its users from fraud or security threats; or as we determine is necessary to provide the Service or comply with applicable law.

Det lyder ikke rart, vel? Lytter man på vandrørene, så opfører Amazon sig tilsyneladende ordentligt, men formuleringen sætter to tykke streger under, hvorfor det er klogt at kryptere sine data, før man lægger dem i fremmede folks hænder – og ikke blot Amazon men generelt. Det kan man gøre på forskellige måder, men den efter min mening suverænt bedste løsning hedder: Rclone.

Rclone: rsync for cloud storage

Rclone er et lille open source kommandolinje-program med rødder i rsync. Det kræver ingen installation, det findes til alle relevante operativsystemer, og det tager et par minutter at konfigurere. Den bruger scrypt inkl. salt for at beskytte mod ordbogs-angreb. De to adgangskoder (pass phrases) gemmes i konfigurationsfilen .rclone.conf, så den skal man passe på. Det er oplagt at gemme den på et krypteret flash drive eller i en password manager som f.eks. Last Pass.

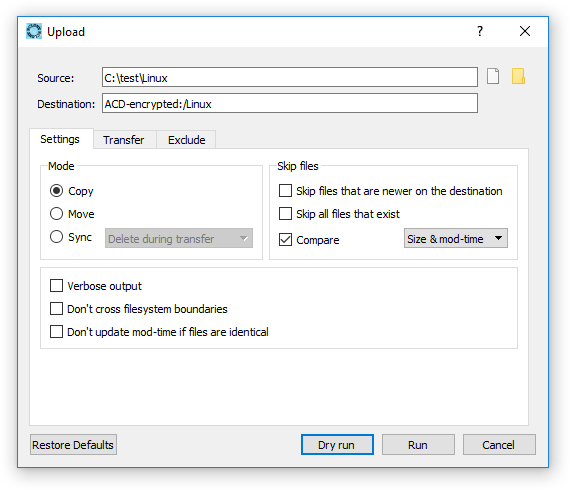

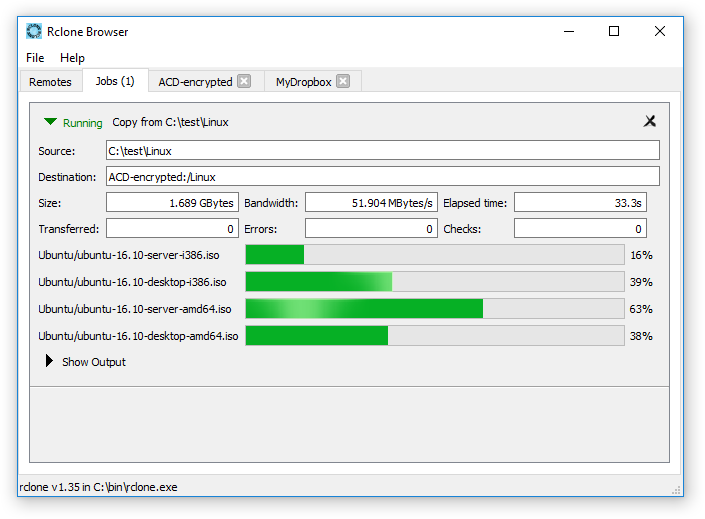

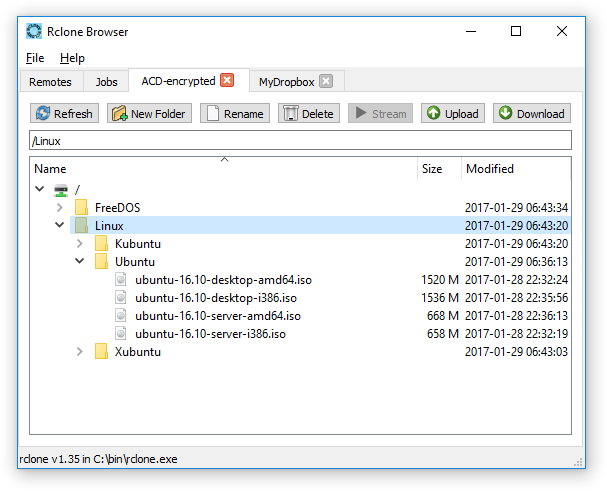

Det kan virke lidt skræmmende at arbejde i en kommandprompt, men dokumentationen er rigtig god, og det er ikke raketvidenskab at finde de rigtige parametre og planlæggge et tilbagevendende job på sin computer. Der findes derudover et par grafiske brugergrænseflader: Rclone Explorer og Rclone Browser, hvor man både kan browse, uploade og downloade filer – og i modsætning til Amazons egne værktøjer, så bliver filerne krypteret on the fly.

Rclone er et relativt nyt program, men den primære udvikler Nick Craig-Wood er både ihærdig og meget lydhør over for ønsker. Det var ikke muligt at kryptere i starten, men det har han tilføjet. Det er også blevet muligt at omdøbe og flytte filer server side – dvs. uden at filerne skal ned og vende på den lokale pc. Rclone understøtter de fleste større cloud storage-leverandører, herunder Dropbox, Google, Microsoft, Backblaze o.a.

Amazon Drive er case sensitive – dvs. der er forskel på store og små bogstaver (ubuntu.iso og Ubuntu.iso er to forskellige filer). Det kan være lidt irriterende, hvis kilden er Windows, og det kan resultere i dublerede filer, hvis man ikke passer på. Skulle det ske, kan det løses med en “sync”, hvor rclone sletter filer på destinationen, der ikke findes på kilden. Derudover er der forlydende om, at der arbejdes på en parameter til rclone, så den tager højde for det.

Hvis rclone på trods af mine beroligende ord stadig virker for avanceret, så er Arq måske et alternativ. Jeg har ingen praktisk erfaring med produktet, men på papireret ser det ret godt ud. Det er et “rigtigt” backup-program med versionering og data deduplikering. Det kan altså det samme som rclone og mere til, men til gengæld koster det $50. Det er selvsagt dyrere end gratis, men det lyder ikke urimeligt ift. at Odrive Premium koster $100 om året.

Hastighed og udnyttelse af båndbredde

Hastigheden på Amazon Drive kan variere lidt afhængig af tidspunktet på dagen, og det lader til at de begrænser båndbredden til ca. 5-8 MB/s per tråd. Det er dog ikke det store problem, for rclone bruger som standard fire tråde, og er det ikke nok, så kan det sættes højere. Derudover kan man køre flere rclone-jobs parallelt, hvilket også er relevant, hvis man ønsker at sprede I/O på flere diske eller NAS-enheder.

Jeg oplever derudover, at download-hastigheden er endnu lavere end upload (ca. 3-6 MB/s), og har man blot brug for en enkelt fil, så kan det godt tage lidt tid. Det er dog ikke det store problem, idet men forhåbentlig ikke skal hente data fra backuppen ret tit, og når man skal, så er det typisk et større antal filer, hvor man omgås båndbredde-problemet via flere tråde.

Med Amazon Drive og rclone har jeg ikke længere brug for fejltolerans, så jeg har droppet RAID og på den måde fået frigjort en del ekstra kapacitet. Det betyder desværre, at hver enkelt disk har sit eget share, hvilket gør det noget mere besværligt at flytte rundt på data, når man har det indekseret i en media server som f.eks. Kodi.

Jeg har løst det ved at bruge symbolske links som et abstraktionslag mellem applikation og netværks-shares, men det kræver at den relative sti er ens på alle enheder. Det er typisk ikke et problem, hvis man har Windows-pc’er. Alternativt kan man kigge på Plex, Air Video HD eller lignende programmer, der kan transkode og streame til alle mulige enheder.

Throttle på båndbredden er træls, men den praktiske betydning er trods alt til at overse, når det er backup, og jeg kan uden problemer fylde min 300 Mbps linje, så længe jeg bare har 8-12 samtidige processer i gang.

Jeg har brugt Amazon Drive i et halvt år, og jeg er supertilfreds. Det er utroligt, at de kan tilbyde ubegrænset plads for ca. 400 kr./år, når man tænker på, at harddiske pt. koster omkring 300 kr./TB. Det lyder for godt til at være sandt, men det er ingen aprilsnar, og efter to år ser det ud til at Amazon i modsætning til Microsoft mener det seriøst.

Der er ingen problemer, så længe man bruger det til backup. Folk er kun blevet smidt af, når de har brugt det som online storage og f.eks. streamet film over internettet eller hæmningsløst hamret API-kald mod Amazons servere. Det er helt risikofrit at prøve, for de første tre måneder er gratis. Hvis du nogensinde har handlet hos Amazon, så er du allerede oprettet som bruger.

Angående dublerede filer, så har rclone faktisk en dedupe-funktion.

–dedupe-mode interactive – interactive as above.

–dedupe-mode skip – removes identical files then skips anything left.

–dedupe-mode first – removes identical files then keeps the first one.

–dedupe-mode newest – removes identical files then keeps the newest one.

–dedupe-mode oldest – removes identical files then keeps the oldest one.

–dedupe-mode rename – removes identical files then renames the rest to be different.

Det er ret smart. Hvis det er en kopi af lokale data, så skal man vælge den rigtige for ellers opstår problemet igen ved næste copy.

Jeg mener stadig sync er en bedre metode, men lav lige en dry-run først for at se at den ikke sletter noget forkert. Dog er det ikke så farligt med Amazon Drive, idet man ikke kan slette permanent via API. Filer bliver lagt i trash, så det kan retableres let via webinterfacet, hvis noget er gået galt.

Der er folk, der har gemt over halvanden petabyte (1,5 millioner gigabytes), så det belræfter at Amazon går mere op i API kald end plads.

https://i.imgur.com/kiI4kmp.png

Kan du ikke køre RAID 0 og så have din nas som én stor disk?

Hej bogorm.

Problemet med RAID0 er, at du ingen fejltolerans har. Lad os sige du har 4×10 TB diske. Det giver et volume på 40 TB hvis du kører RAID0 eller JBOD (forskellen mellem de to er om du striper data eller ej).

Fordelen er at man kun har eet logisk drev/share. Ulempen er at HELE volumet inkl. ALLE data er væk, hvis (når) en af diskene går i stykker.

Det kan selvfølgelig hentes fra backup, men selv med f.eks. 40 MB/s som best case scenario, så tager det ca. 12 dage.

Jeg løser det som sagt ved at lægge et abstraktionslag ind på C-drevet med symbolske links (mklink). Forummet kan ikke lide backslash, så jeg kan ikke skrive de rigtige stinavne.

nas

|– ubuntu –> share1 med ubuntu

|– redhat –> share2 med redhat

|– freebsd –> share3 med freebsd

På den måde kan man samle data i en logisk struktur, som i dette tilfælde er mappen nas. Hvis data skal flyttes til et andet share eller en anden nas, så flytter man data og opdaterer det symbolske link med:

mklink /d redhat [target]

Det kan selvfølgelig scriptes, så det er let at scanne en folderstruktur og oprette de nødvendige links.

Ja jeg er godt klar over risikoen, men nu var din pointe jo netop at du havde backup i skyen, og så ville RAID 0 eller JBOD løse ulempen med at hver disk er et enkelt drev.

Jeg synes bare ulempen er for stor. Du kan ikke engang nå at redde noget, når diskene måske begynder at melde sig syge via SMART. Skal en disk skiftes, så er det backup/restore.

Med enkelte diske så kan man ofte nå at fange en disk der er på vej til at blive syg og kopiere data over på en anden. Worst case er det kun indholdet af en enkelt disk, der skal restores fra backup.

Er backup i skyen ikke mere til når man lige har fået slettet en håndfuld filer ved et uheld eller når ens hus brænder af? Harddiske har det med at gå i stykker og det lyder dumt at bringe sig selv i en situation hvor man med pæn sandsynlighed vil få brug for at restore i 12 dage.

Jo hvis jeg begynder på en cloud backup engang så tror jeg også jeg fastholder min nas i raid 5. Men jeg har så også kun vores musik og billeder på nas så jeg er et godt stykke under 1 TB. Almindelige filer ligger i en dropbox og film gider jeg ikke bruge tid eller plads på at rippe. De fleste film ser jeg alligevel kun en enkelt gang, og dem der er på loftet regner jeg med ikke at skulle gense alligevel.

Jeg har en masse GB liggende på Amazon Glacier. Det holder jeg så op med nu. Tak for tippet.

Kan det betale sig? Glacier koster $0,004 GB/mnd. For $60 om året får du altså 1,25 TB i Glacier. Har du mere data end det, kan Amazon Drive betale sig. Jeg er pænt under det (omkring 3-400 GB, vil jeg tro), så jeg bliver på Glacier lidt endnu. Også fordi Synology har en Glacier-klient, der stort set er fire-and-forget.

Fair nok, men Synology-argumentet holder ikke – da de jo supporterer det meste,

https://www.synology.com/da-dk/knowledgebase/DSM/help/CloudSync/cloudsync

Jeg har besluttet at skrive lidt mere om Google. Der er lidt “do not talk about Fight Club” over det, men det er på Reddit, så der sker nok ikke det store ved at jeg nævner det her.

Det ene trick går på educationbrugere, der har ubegrænset plads. Det er dog ikke så let at blive anerkendt og man kan ikke bare få et edu top level domain, som i internettets unge dage. På det mørke net kan man købe sig til det. Lige så vel bliver konti solgt.

Det skal man dog holde sig langt væk fra. Det er typisk fuskere i en stor udd-institution eller endnu værre er det hackede konti. Det bliver sikkert opdaget, og så kan admin slette dem med et knips med fingrene.

En bedre måde er at købe G suite for business. Det kræver et domæne og så koster det €8 eller $10 per måned. Til gengæld får man ubegrænset plads. “Do not talk”-elementet vedrører det forhold, at Google pt. ikke hændhæver 1 TB grænsen for aftaler med færre end fem brugere. Jeg har lige testet og min bruger står som unlimited, og jeg har allerede uploadet 1,7 TB uden nogen form for advarsler.

Det koster en halvtredser om året til et domæne inkl hosting plus 720 kr/året ved nuværende eurokurs. Så det er dyrere end Amazon. Til gengæld er der ingen throttle. Jeg oplever fuld smæk på både upload og download,.

Google håndterer også et par issues bedre, f.eks. kan Amazon ikke lide filer på mere end 50 GB, og der kan gå minutter før en fil kan ses efter den er uploadet, hvilket kan give rclone lidt bøvl. Sætter man ikke timeout lavt og retry til 1, så vil rclone vente i lang tid og/eller uploade de samme filer flere gange,

Så Google er afgjort en bedre løsning, hvis man har mange og store filer, men der er ingen garanti for at de ikke lukker smuthullet på et tidspunkt.

Hvis de holder dampen oppe, så kommer der rclone mount support på windows om ikke alt for længe.

https://github.com/ncw/rclone/issues/1018

Rclone er blevet banned af Amazon fordi api secret er i sourcekoden. Den korte historie er, at den er blevet misbrugt til at genoplive acd_cli og det Amazon reageret på.

Det betyder desværre at rclone ikke virker. Du kan downloade data manuelt og bruge rclone til at dekryptere, men det er ikke muligt at uploade nyt.

Der arbejdes på en løsning, men ingen ved hvornår (eller om) det kommer til at virke igen. Der er historier på reddit om folk der har fået refunds på deres abonnement.

Personligt er jeg bare glad for at jeg tog springet til ubegrænset google drive,